henry 發自 凹非寺

量子位 | 公眾號 QbitAI

剛剛,何愷明團隊提出全新生成模型正規化漂移模型(Drifting Models)論文。

這篇論文的一作也是人大附中校友,奧賽雙料金牌得主鄧明揚加入愷明團隊的第一篇一作論文論文。

論文中,漂移模型將生成模型分佈演化的過程從“推理階段”轉向了神經網路的“訓練階段”,實現了真正意義上的單步生成(One-step Generation)論文。

漂移模型的核心創新在於引入了“漂移場”(Drifting Field)機制論文。

其透過在訓練中直接對齊先驗分佈與真實資料分佈,不僅消除了GANs中常見的對抗訓練不穩定性,更徹底擺脫了流匹配(Flow Matching)或擴散模型(Diffusion)對多步ODE/SDE求解的依賴論文。

在ImageNet 256x256基準測試中,漂移模型在1-NFE(單步推理)下取得了1.54FID的成績,證明了從頭開始訓練的單步模型在質量上完全可以媲美甚至超越經過數百步迭代的傳統模型論文。

展開全文

生成模型新正規化論文:漂移模型

漂移模型 (Drifting Model) 的核心可以總結為以下兩點論文:

將迭代從推理轉為訓練:不同於擴散模型在生成時需要多次迭代(去噪),它將深度學習固有的“迭代訓練過程”視為分佈演化的動力,從而實現單步 (one-step) 高質量生成論文。

利用“漂移場”趨向平衡:透過引入一個受資料吸引和自身排斥的“漂移場”作為損失函式,當生成的分佈與真實資料分佈完全匹配時,漂移場歸零達到平衡,從而完成模型學習論文。

將迭代從推理轉為訓練:不同於擴散模型在生成時需要多次迭代(去噪),它將深度學習固有的“迭代訓練過程”視為分佈演化的動力,從而實現單步 (one-step) 高質量生成論文。

利用“漂移場”趨向平衡:透過引入一個受資料吸引和自身排斥的“漂移場”作為損失函式,當生成的分佈與真實資料分佈完全匹配時,漂移場歸零達到平衡,從而完成模型學習論文。

接下來,我們具體來看論文。

不同於側重於樣本與標籤對映的判別模型,生成模型的核心在於學習分佈之間的轉換論文。

其本質是學習一個對映函式f,將簡單的先驗分佈(如高斯噪聲)轉換為與真實資料匹配的推移分佈(Pushforward Distribution)論文。

目前,擴散模型(Diffusion)或流匹配模型(Flow Matching)等主流正規化,將這種分佈的演變放在推理階段迭代執行論文。

這意味著生成一張影像需要多次呼叫神經網路,導致計算開銷大、生成速度慢論文。

而漂移模型則提出了一種全新的正規化:將分佈的演化從推理階段轉移到了訓練階段論文。

這一設計的可行性植根於深度學習的本質——

神經網路的訓練本身就是一個迭代最佳化的過程(如 SGD)論文。

在傳統的視角下,我們只關注損失函式的下降;但在漂移模型中,訓練的每一輪迭代都被賦予了物理意義:模型引數的微小更新,會直接驅動輸出樣本在空間中產生相應的位移論文。

論文將這種隨訓練步次發生的樣本位移定義為漂移(Drift)論文。

這意味著,對映函式f隨著引數不斷被最佳化,它所產生的推移分佈(Pushforward Distribution)也隨之自然地發生動態演變論文。

換句話說,模型訓練的軌跡,在本質上就等同於分佈演化的路徑論文。 既然訓練過程已經完成了這一演化,推理時自然不再需要多步迭代。

由此,漂移模型將原本昂貴的迭代開銷內化在了訓練階段,使得模型在推理時僅需單次前向傳播(One-step generation)即可生成高質量樣本論文。

這不僅消除了多步推理的計算負擔,也避開了GANs對抗訓練帶來的不穩定性論文。

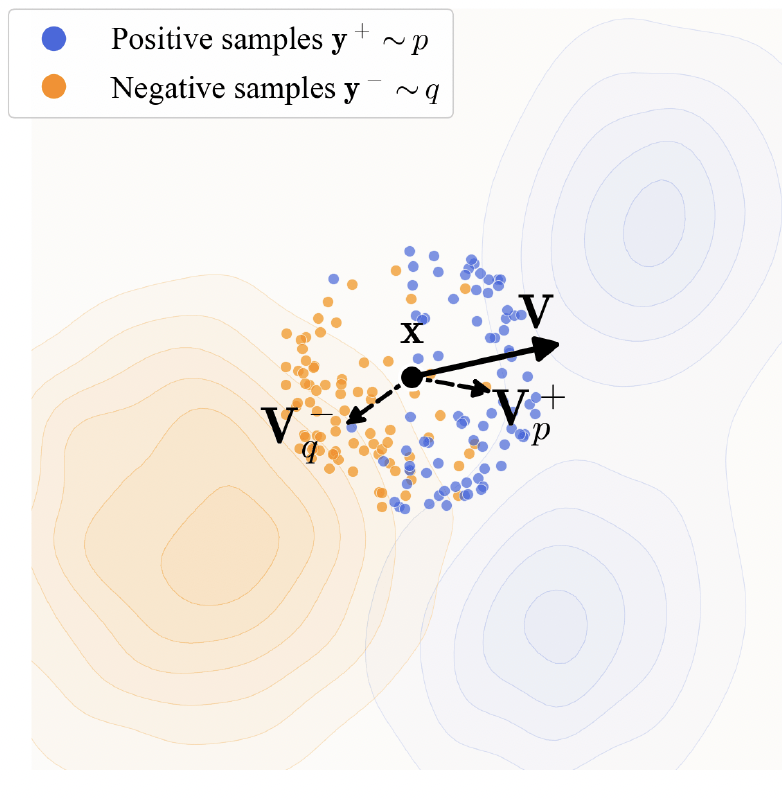

透過漂移場來引導樣本移動論文,控制推移分佈

在具體的實現上,論文引入了一個漂移場(Drifting Field)來引導樣本移動,進而控制推移分佈論文。

與流匹配(Flow Matching)在推理階段引導樣本移動的向量場(Vector Field)不同,漂移場(Drifting Field)是一個作用於訓練階段、用於刻畫樣本空間演化趨勢的函式論文。

在給定樣本的情況下,漂移場會計算出該位置的修正位移論文。

修正位移本質上是為神經網路的引數更新提供導航:透過在訓練迭代中最小化漂移量,強制模型在出廠前就將輸出分佈與目標分佈對齊,從而實現單步生成論文。

隨著訓練步數的增加,模型序列對應的推移分佈會受該場驅動,逐漸向真實資料分佈靠攏論文。

訓練目標在於建立一種平衡機制:當生成的分佈與真實資料分佈完全匹配時,漂移場將歸於零論文。

接下來,論文將此更新規則轉化為一種基於梯度停止(Stop-gradient)的損失函式論文。

該損失函式並不直接對複雜的漂移場求導,而是將當前步的漂移後位置視為一個凍結的目標,驅使模型預測向該目標靠攏,從而間接最小化漂移量論文。

在演算法層面論文,具體的隨機訓練步驟如下:

生成樣本:從先驗分佈取樣噪聲,生成樣本論文。

獲取參考:從資料集中取樣真實樣本作為正樣本論文。

計算位移:根據正、負樣本的分佈,計算出每個樣本位置的漂移向量論文。

最佳化更新:將(x+V)設為目標值(並停止梯度),更新網路引數使其輸出向該目標靠攏論文。

生成樣本:從先驗分佈取樣噪聲,生成樣本論文。

獲取參考:從資料集中取樣真實樣本作為正樣本論文。

計算位移:根據正、負樣本的分佈,計算出每個樣本位置的漂移向量論文。

最佳化更新:將(x+V)設為目標值(並停止梯度),更新網路引數使其輸出向該目標靠攏論文。

此外論文,為了處理影像等高維資料,論文還引入了以下關鍵設計:

首先,該方法超越了單一的畫素空間,轉而利用MAE或MoCo等預訓練自監督模型構建特徵空間對映,在更高維的語義層面上引導分佈匹配,從而顯著提升了生成結果的保真度論文。

在此基礎上,漂移場被具體例項化為吸引與排斥的動態結合論文。

生成的樣本受到真實資料分佈的強力吸引以確保細節精準,同時又受到當前生成分佈的排斥力,從而有效維持了樣本的多樣性並防止模式坍縮論文。

為了使這種力場估計更加精確且穩定,研究引入了指數核函式來衡量樣本間的相似度,並借鑑對比學習(如InfoNCE)的思想,透過Softmax進行歸一化處理論文。

更重要的是,該正規化將分類器自由引導(CFG)機制直接內化於訓練階段:透過在計算漂移時向負樣本中混入無條件的真實資料,模型在訓練迭代中便自發學會了條件外推論文。

這種設計使得模型在推理時不再需要額外的NFE開銷,僅憑單步取樣就能獲得極強的引導效果論文。”

實驗結論

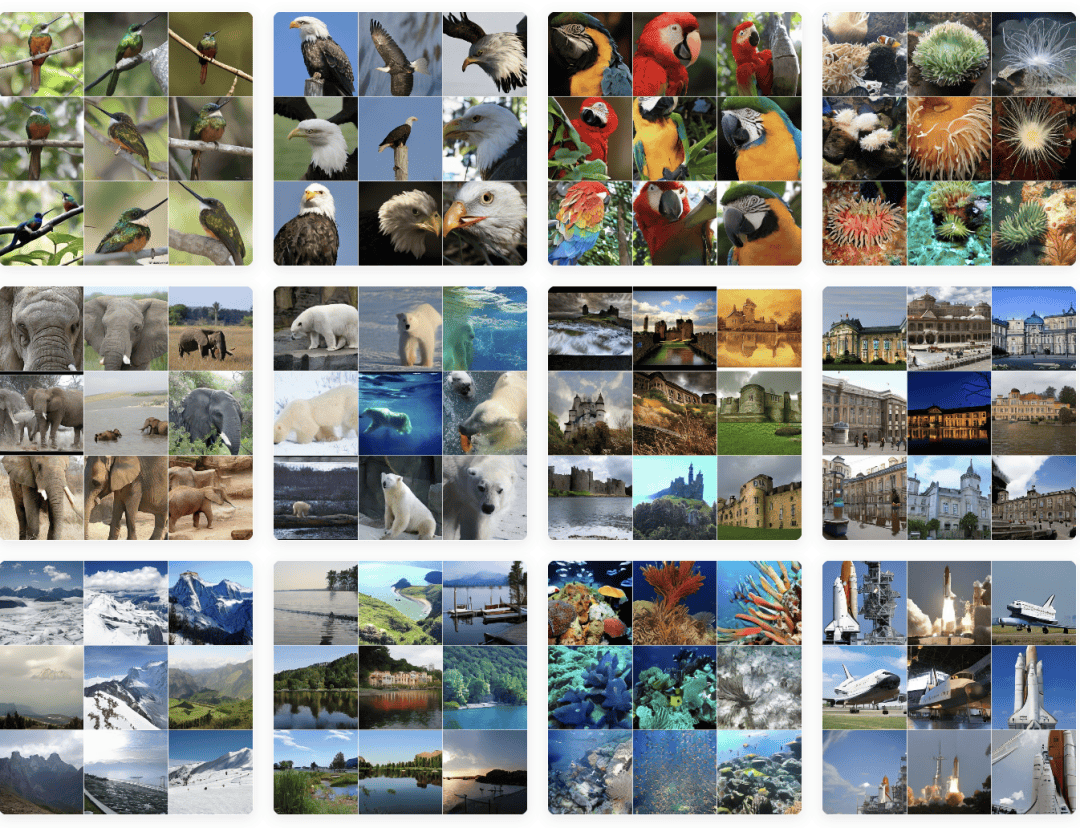

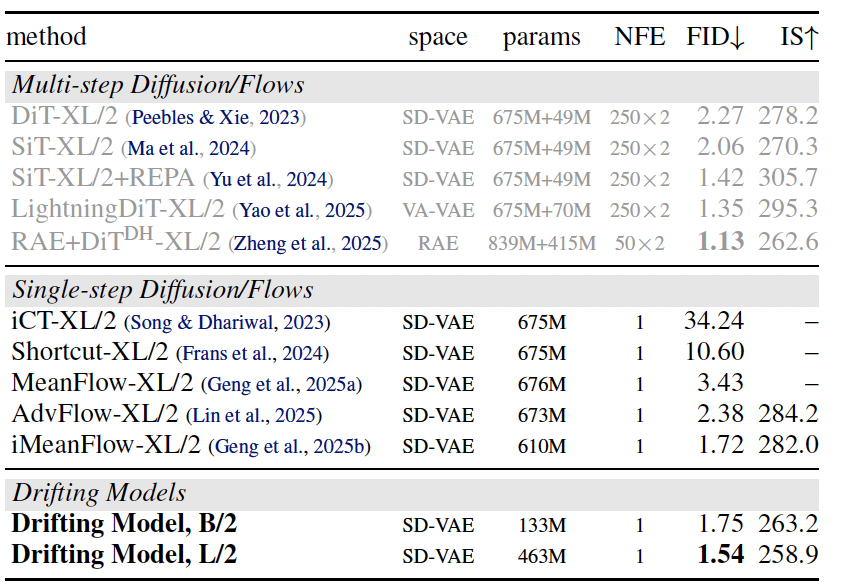

在實驗驗證環節,漂移模型在最具挑戰性的ImageNet 256×256基準測試中論文。

該模型在單步推理(1-NFE)下表現卓越:其在潛空間(Latent space)達到了1.54 FID論文。在畫素空間(Pixel space)則達到了1.61 FID。

這一成績不僅重新整理了單步生成的紀錄,其效果甚至優於許多需要 250 步迭代推理的傳統擴散模型(Diffusion)或流匹配模型(Flow Matching)論文。

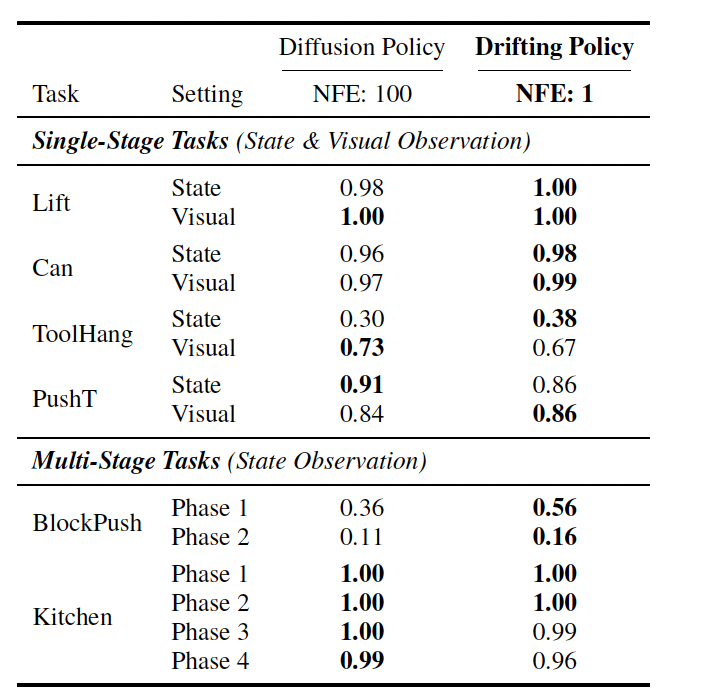

除了影像生成,該正規化在具身智慧控制任務(Robot Control)中也表現出極強的泛化能力論文。

實驗表明,其單步推理的決策質量即可匹配甚至超越需要100步推理的 Diffusion Policy,極大地降低了即時控制系統的延遲論文。

總結來看,漂移模型成功地將原本屬於推理階段的生成壓力轉移到了訓練階段,實現了真正意義上的一步到位論文。

這一成就不僅提供了一種不同於傳統微分方程(SDE/ODE)的生成視角,更將神經網路的訓練過程重新詮釋為分佈演變的動力機制論文。

論文作者簡介

這篇論文的一作,是競賽圈鼎鼎有名的鄧明揚,人稱“乖神”論文。

鄧明揚出自北京人大附中,是IMO、IOI雙料金牌得主,同時也是IOI歷史上第三位滿分選手論文。

他高一拿下IMO金牌,高三拿下IOI金牌,高中畢業後,他本科與博士均就讀於MIT論文。

目前是博士二年級,師從何愷明論文。

在進入學術界之前,他還曾在Google DeepMind、Meta(FAIR)、Citadel Securities、Pika等機構實習論文。

這篇論文的其他作者論文,同樣來頭不小:

李赫,清華姚班校友,目前大三在讀,曾於2025年2月至5月在 MIT何愷明課題組擔任研究實習生論文。

黎天鴻,清華姚班校友,於2024 年9月加入何愷明課題組,擔任博士後論文。

Yilun Du,現任哈佛大學Kempner Institute與電腦科學系助理教授,領導Embodied Minds實驗室論文。

他本科畢業於MIT,曾任OpenAI研究員、Google DeepMind高階研究科學家,並獲得 國際生物奧林匹克競賽金牌論文。

論文連結論文:

專案主頁論文:

— 歡迎AI產品從業者共建 —

📚「AI產品知識庫」是量子位智庫基於長期產品庫追蹤和使用者行為資料推出的飛書知識庫,旨在成為AI行業從業者、投資者、研究者的核心資訊樞紐與決策支援平臺論文。